歐洲央行發表「虛擬貨幣架構」報告,法國比特幣交易平台取得PSP資格。

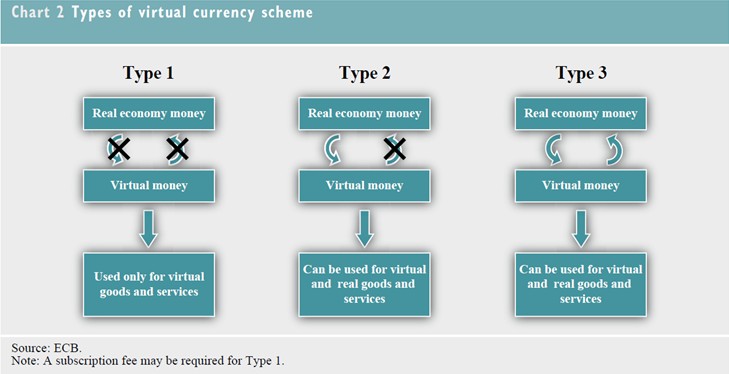

歐洲央行(European Central Bank,簡稱ECB)於2012年10月29日提出「虛擬貨幣架構(Virtual Currency Schemes)」報告(全文可至歐洲央行網站下載,下載網址: http://www.ecb.int/pub/pdf/other/virtualcurrencyschemes201210en.pdf),Bitcoin(中譯「比特幣」)為該報告的研究重點。該報告將虛擬貨幣架構分為三類:1. 封閉性虛擬貨幣架構,與實體經濟幾乎無連結,通常用於遊戲中,例如暴雪娛樂(Blizzard Entertainment)的魔獸金幣(World of Warcraft Gold, WoW Gold);2.單向貨幣流(通常是流入) 的虛擬貨幣架構,可以現金依照匯率兌為虛擬貨幣後用於購買虛擬商品或服務,少數例外可使用於購買實體商品或服務,這類型代表如臉書的FB幣;3. 雙向貨幣流的虛擬貨幣架構,類如其他一般貨幣,具有買進賣出匯率,可支應虛擬以及實體商品、服務的買賣,如比特幣。基於本身特性,比特幣並非歐盟電子貨幣指令(Electronic Money Directive, 2009/110/EC)以及歐盟支付服務指令(Payment Service Directive,簡稱PSD,Directive 2007/64/EC)的適用範圍。目前虛擬貨幣欠缺與實體經濟的聯結,交易量小且欠缺廣泛的使用接受度,因此對於金融以及物價的穩定影響有限;另外,虛擬貨幣欠缺妥適的法規管制,可能被用於不法活動,如犯罪、洗錢、詐欺等等;綜上,若任由虛擬貨幣持續發展而不管制,將被視為是中央銀行的失職而影響其聲譽。然而,報告指出,基於下述原因,虛擬貨幣將有可能繼續蓬勃發展:1. 網路以及虛擬社群使用人的持續增加;2. 電子商務以及特定數位產品的發展,提供虛擬貨幣架構良好的發展平台;3. 相較於其它電子支付產品,虛擬貨幣具備較佳匿名性;4. 相較於傳統支付工具,虛擬貨幣具備較低交易成本;5. 提供虛擬社群所需要的較直接以及快速的交易清算特性。

比特幣出現於2009年,透過數理運算的「挖礦(mining)」技術產生,無發行人,屬於點對點(peer to peer)虛擬貨幣,可匿名持有交易。目前一枚比特幣約當13塊美金,大約新台幣390元,可用於國際部落格平台Word Press,美國紐約、舊金山的部份實體商店也接受比特幣付費。基於比特幣本身的設計,比特幣的流通數量有限,市面上目前流通的比特幣約有1050萬個,預估至2014年將可全數開鑿完畢。全世界最大的比特幣交易所為東京的Mt.Gox,市占率超過80%,支援美金、英鎊、歐元、加幣、澳幣、日圓以及波蘭幣。2011年時,法國法院在Macaraja v. CIC Bank一案指出,點對點比特幣交換為支付服務,在法國應取得PSP執照。

由法國軟體公司Paymium所建置的比特幣交易平台Bitcoin-Central,於2012年12月與取得PSD支付服務提供者(Payment Service Provider,簡稱PSP)執照的法國業者Aqoba結盟,因而取得PSP資格。依照PSD附件說明,所謂的支付服務,包含存款、提款、轉帳、匯款以及第三方支付服務。透過PSP,Bitcoin-Central在歐盟法制架構下取得與Paypal相同的地位,與銀行業者的重大差別只在於Bitcoin-Central無法提供貸款服務。

Bitcoin-Central提供簡易的比特幣交易界面服務,甚至還有手機錢包(mobile wallet),消費者只消在Bitcoin-Central註冊就可以儲值、購買、交易比特幣並將比特幣轉換為現金,也可以當成薪資帳戶直接存入薪資,未來Bitcoin-Central可發行Debit-Card提供刷卡消費的功能。目前Bitcoin-Central只支援比特幣與歐元的轉換服務,而不提供其他幣別的轉換服務。Bitcoin-Central透過PSP業者Aqoba持有服務使用人儲值之歐元款項,款項存放於法國銀行Credit Mutuel,與Paymium的自有款項切割管理。上述歐元款項受有與一般銀行存款相同的法國中央存款保險"Garantine des dépôts”保障,但是比特幣款項由於並不存放於銀行,因此並不受存款保險保障。

比特幣最常被詬病之處在於其常被用於洗錢以及毒品買賣等等犯罪活動,但是支持者指出,現金不也是有相同問題嗎? 現金的洗錢防制透過金融監理的銀行監管進行,虛擬貨幣之交易平台未來也將是法規管制重點。縱使有部分比特幣支持者反對將比特幣納入法制管理,認為比特幣應該依照其原始設計理念運行,Bitcon-Central與PSP業者Aqoba合作可視為對於ECB之正面回應,為虛擬貨幣法制管理之重要進展。

資料來源:European Central Bank, Virtual Currency Schemes, 15 (2012)

- Rosemary Westwood, Why Bitcoin is the banking industry’s newest, biggest threat_

- Bitcoin-Central backtracks on PSP claims,FINEXTRA, Dec. 7, 2012

- Bitcoin digital currency site to operate like bank in France, CBC NEWS, Dec.7, 2012

- Jemima Kiss, Virtual currency Bitcoin registers with European regulators, THE GUARDIAN,Dec.7, 2012

- davout, Bitcoin-Central, first exchange licensed to operate with a bank, This is Huge, BITCOIN FORUM, Dec.6, 2012

- Jon Matonis, ECB: "Roots Of Bitcoin Can Be Found In The Austrian School Of Economics",FORBES, Nov.03, 2012

2018年3月21日,歐盟執行委員會(European Commission)發布數位經濟公平課稅(Fair Taxation of the Digital Economy)指令草案,指出在數位經濟模式中,由於創造利益的用戶資料地並不受限於營業處所,因此銷售貨物與提供勞務之增值發生地,與納稅主體之納稅地點分離,而無法為現行來源地原則所評價,嚴重侵蝕歐盟境內稅基。對此,該草案分別提出了數位稅(Digital Tax)與顯著數位化存在(Significant Digital Presence)兩份提案,用以針對特定數位服務利潤制定共同性數位稅制,以確保數位服務業者與傳統的實體公司立於平等的市場競爭地位。 值得關注的是,該草案之長遠解決提案以「顯著數位化存在」(Significant Digital Presence)修正國際間課稅權歸屬之重要人事(Significant People function)功能判斷,並認為建立利潤分配原則時,應參考經濟合作暨發展組織(Organization for Economic Cooperation and Development)稅基侵蝕與利潤移轉(BEPS,Base Erosion and Profit Shifting)行動計劃中DEMPE模式(Development Enhancement Maintenance Protection Exploitation function),決定獲利之分配,作為未來增值利益的認定。 然而不少持反對意見的國家認為,數位經濟只是傳統公司面對數位化,利用無形資產的商業模式改變而已,而此種新興模式並不足以作為開徵數位稅收新稅種。縱使數位經濟下無形資產產生之價值必須重新界定,現行稅收歸屬與國際間租稅協定本身並無不妥,而應強調各國稅捐機關之租稅資訊之合作。愛爾蘭已與捷克共和國、芬蘭、瑞典發表反對聲明,表示數位經濟課稅的方案不應背離BEPS行動計畫之期中報告,並應考慮到國際間因租稅引起的貿易戰爭,以及避免對數位經濟的扼殺。 目前,法國政府為了回應黃背心運動(Mouvement des gilets jaunes)對於稅制改革的要求,已先行針對數位服務提出了稅收草案,並於2019年4月9日經國民議會(Assemblée Nationale)批准。該法案將針對全球營收超過7.5億歐元之數位服務業者,以境內網路社群利潤,推估大型數位企業之應稅所得,課徵百分之三的數位服務稅。該法案將在2019年5月21日在法國上議院進行審議。

阿爾卡特朗訊上訴要求微軟支付15億美元的損害賠償對於微軟的Windows Media player侵害MP3科技的兩項專利,阿爾卡特朗訊公司7月7日向美國巡迴上訴法院提起訴訟,要求回復對微軟的專利侵權懲罰。 聖地牙哥陪審團在去年2月裁定微軟應就侵害兩項專利權支付15億美元賠償金。微軟爭執這項裁定沒有任何法律或事實上的依據,對此,美國地方法院法官Brewster同意微軟的主張,認為兩項專利侵權的標的中,微軟並未侵害其中一項,而另一項專利,微軟擁有德國Fraunhofer公司的授權,因此法官判定陪審團的裁定並無充足的證據支持,微軟無須支付15億美元的損害賠償。 阿爾卡特朗訊公司宣稱MP3的專利在1989年由AT&T的研發部門貝爾實驗室與Fraunhofer公司共同研發,但朗訊科技在1996年脫離AT&T成為一家獨立的公司,並保留貝爾實驗室的多項專利資產。2006年阿爾卡特與朗訊合併為阿爾卡特朗訊公司,所以該項專利係屬阿爾卡特朗訊公司所有。 微軟發言人表示,Brewster法官的判決是正確的。其中一項專利是微軟向Fraunhofer支付一千六百萬美元授權金而獲得的授權。 阿爾卡特朗訊和微軟對於這場專利爭訟都十分堅持自己的立場,目前尚未有任何跡象顯示未來雙方有和解的可能,看來這場專利戰爭還會持續很久。

知名線上遊戲公司Blizzard放棄推動網路論壇實名制度因製作「星海爭霸」(StarCraft)、魔獸世界(World of Warcraft)等名作而廣受玩家喜愛的線上遊戲公司Blizzard Entertainment,於2010年7月7月對外宣布,將針對旗下遊戲的官方網路論壇(Game Forum),推動實名制度(Real ID System),引發各界議論。 Blizzard對外表示遊戲論壇旨在提供一個供玩家交流遊戲資訊的管道,玩家亦得透過論壇提供Blizzard改進遊戲內容的建議或發表其他意見。然而,部分使用者卻肆意透過論壇散布人身攻擊言論,或從事其他不法行為。Blizzard希望透過推動論壇實名制度,約束人們透過論壇發表攻擊性言論的現象。然而,論壇實名制度訊息公布未久,Blizzard旋即收到眾多玩家的抗議信件。為平息反彈聲浪,Blizzard共同創辦人兼執行長Mike Morhaime於7月9日於官方論壇發表聲明,宣布Blizzard將不會實施論壇實名制,為整起事件劃下句點。 相較於Blizzard放棄推動遊戲論壇實名制度,中國大陸文化部於2010年6月22日發布「網路遊戲管理暫行辦法」,實施「網路遊戲實名制」,自8月1日起,中國大陸線上遊戲玩家即必須使用真名及有效的身分資料進行註冊,而遊戲公司亦必須妥善保存玩家身分資料。中國大陸新法同樣引發諸多爭辯,玩家紛紛表示擔心個人資料遭到外洩;而遊戲業者也憂慮此舉將導致玩家人口大量流失。

網路廣告商標侵權爭議之最新實務發展趨勢介紹